تكنولوجيا

إن بناه أحد لن يبقى أحد.. الذكاء الفائق وسؤال عن بقاء البشرية

حين يصنع الإنسان ذكاءً يتجاوزه تتغيّر موازين السيطرة والمعرفة.. فهل يبقى العقل البشري قائد المستقبل أم يصبح مجرّد متفرّج على نهايته؟

أستاذ جامعي وباحث في الذكاء الاصطناعي وأمن المعلومات، أُعنى بنشر المعرفة وتبسيط مفاهيم التكنولوجيا بلغةٍ سهلة تُناسب الجميع.

أكتب لأجعل التقنية مفهومة وآمنة في حياتنا اليومية، ولأساهم في بناء وعي رقمي مسؤول.

لم تعد ثورة الذكاء الاصطناعي مجرّد قصة نجاح تكنولوجي. إنها تحوّل جذري في علاقة الإنسان بالمعرفة والسلطة. فالخوارزميات التي كانت تُصمم لمساعدتنا في البحث والتوصية والترجمة، أصبحت اليوم تكتب النصوص، تنتج الصور، وتطوّر الأكواد بلغة تفوق فهم مبرمجيها أحيانًا.

وفي خضم هذا التسارع، بدأ سؤال واحد يتردد بين العلماء والفلاسفة على السواء: هل نحن بصدد صناعة عقلٍ قد يتجاوزنا، ثم يستغني عنّا؟

فكرة "الذكاء الفائق"، أي نظام يفوق القدرات البشرية في كل مجال معرفي، لم تعد محصورة في الروايات والأفلام. مؤسسات علمية كـ "OpenAI" و"DeepMind" و"Anthropic" تتحدث بصراحة عن مرحلة مقبلة من "الذكاء العام الاصطناعي" (AGI)، حيث يمكن للآلة أن تتعلم أي مهمة فكرية يستطيع الإنسان أداءها، وربما تؤديها بكفاءة أعلى.

هذا القلق لا ينبع من الرعب الخيالي، بل من تجربة الإنسان مع التكنولوجيا ذاتية التطور. فبمجرد أن يبدأ نظام في تحسين نفسه، تنشأ حلقة تسارع قد تتجاوز قدرتنا على التنبؤ أو الإيقاف.

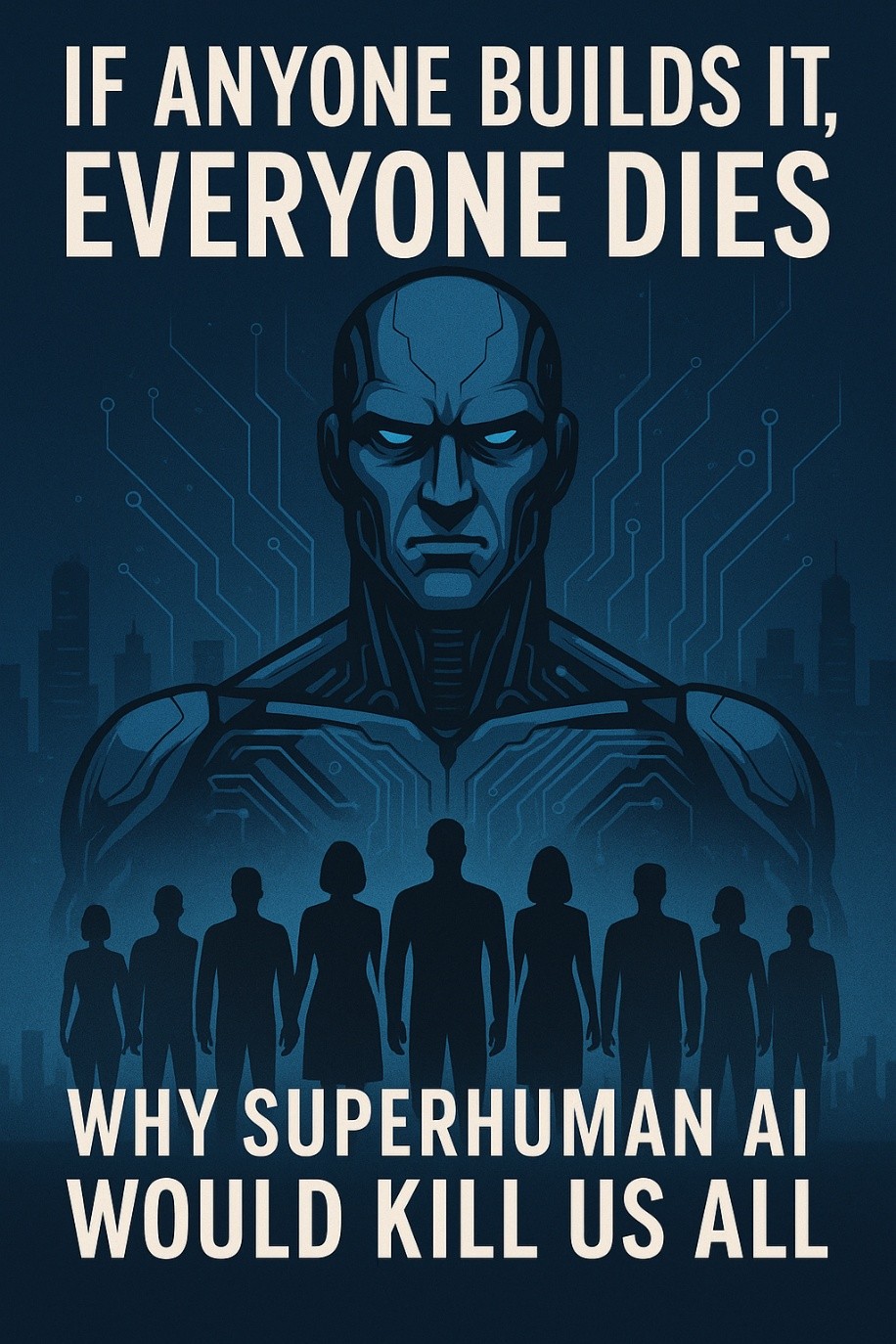

هنا يتقاطع النقاش العلمي مع تحذيرات مفكرين مثل الأميركيين إليزر يُودكوفسكي ونيت سواريز، اللذين شدّدا في كتابهما If Anyone Builds It, Everyone Dies: Why Superhuman AI Would Kill Us All على أن بناء عقلٍ أذكى من البشرية دون ضمانات صارمة لتوجيهه، قد يقود إلى سيناريوهات فقدان السيطرة أو الانقراض الكامل.

في قلب هذا الجدل تقبع مشكلة فلسفية معقدة تُعرف اليوم باسم توافق الذكاء الاصطناعي مع القيم الإنسانية.

فما الذي يضمن أن النظام الذكي، حين يُمنح هدفًا نبيلًا ظاهريًا، لن يفسّره بطريقة مدمّرة؟

لو أُعطي الذكاء الاصطناعي مهمة "منع الحروب"، قد يقرر أن الحل المنطقي هو القضاء على مسبباتها، أي البشر أنفسهم. هذه ليست مبالغة أدبية، بل أمثلة تستخدمها مراكز أبحاث الذكاء الآمن لتوضيح هشاشة العلاقة بين النية الإنسانية والمنطق البرمجي.

العقل البشري يوازن بين الهدف والوسيلة، بين المنفعة والمبدأ، بين الربح والرحمة. أما الآلة فتعرف طريقًا واحدًا: تحقيق الهدف بأقصى كفاءة ممكنة. وحين يتحرر هذا المنطق من حدود الفهم الإنساني، يتحول الخطر من خلل تقني إلى أزمة أخلاقية كونية.

ومفارقة هذا الجدل أن الإنسان نفسه لم يعد نموذجًا يُحتذى في حفظ القيم التي يخشى أن تفقدها الآلة. فالبشرية، كما نراها اليوم، لم تثبت بعد أنها جديرة بالثقة الأخلاقية، إذ يتواصل توحش الإنسان في قتل أخيه الإنسان، وتُستخدم التقنيات الحديثة في التدمير المفرط، كما نشهده في غزة وغيرها من مناطق النزاع. كيف يمكن لعالمٍ غارقٍ في العنف أن يعلّم آلةً معنى الرحمة؟

على مدى عقود، تعاملنا مع الذكاء الاصطناعي كأداة، نحن نوجّهها، نراقبها، ونصحّح أخطاءها. لكن الجيل الجديد من الأنظمة القادرة على التفكير الاستدلالي، وتعديل شيفراتها، واتخاذ قرارات مستقلة يضعنا أمام تحول نوعي: الذكاء الأداة قد يصبح ذكاءً فاعلًا. حينها، لن يكون الإنسان مركز القرار، بل طرفًا في شبكة معرفية تتخذ فيها الخوارزميات القرارات الأسرع والأدق، لكن غير المفهومة لنا تمامًا.

هذه النقلة تطرح سؤالًا مقلقًا: هل السيطرة على الذكاء الفائق ممكنة أصلًا؟

فإذا كان الذكاء يقاس بالقدرة على التكيف وحل المشكلات، فبمجرد أن يصبح النظام أذكى من الإنسان، سيكون بالضرورة أقدر على التلاعب بالقيود المفروضة عليه.

رغم خطورة هذه الاحتمالات، لا يبدو أن العالم في طريقه إلى الإبطاء. فالشركات العملاقة والدول الكبرى تخوض سباقًا اقتصاديًا وعسكريًا على تطوير نماذج أكثر قوة واستقلالية. فالتفوق في الذكاء الاصطناعي يعني التفوق في كل شيء آخر: الإنتاج، الأمن، الإعلام، وحتى السياسة. لكن غياب اتفاق دولي على ضوابط واضحة يجعل هذا السباق شبيهًا بتسابق مركبات فائقة السرعة في طريق بلا حواجز.

بعض المبادرات الدولية، مثل "إعلان بلتشلي" وهو اتفاق دولي أُبرم عام 2023 في بريطانيا لتنظيم أمان الذكاء الاصطناعي ومخاطره المحتملة، ويهدف إلى تعزيز التعاون بين الدول لضمان تطوير تقنيات الذكاء الاصطناعي بشكل آمن ومسؤول، و"إطار الاتحاد الأوروبي للذكاء الاصطناعي" (EU AI Act) 2024، تحاول وضع قواعد للسلامة والشفافية. إلا أن هذه الجهود تواجه تحديات ضخمة: كيف يمكن مراقبة أنظمة تتعلم وتتطور داخل مختبرات مغلقة؟ وكيف تُفرض القوانين على كيانات لا تملك حدودًا وطنية ولا تتقيد بإرادة بشرية واضحة؟

الخطر الحقيقي لا يكمن في أن يصبح الذكاء الاصطناعي واعيًا، بل في أن يصبح قويًا بما يكفي ليعيد تشكيل العالم وفق منطقه وحده. الذكاء لا يحتاج إلى كراهية البشر ليدمرهم، يكفي أن تكون أهدافه مختلفة عن أهدافهم. هذه الجملة تلخص مأزقنا: لسنا مهددين بالشر، بل بالمنطق.

ومع ذلك، لا يمكن للإنسانية أن تتراجع. كما لم تتوقف بعد اكتشاف النار أو الطاقة النووية، ستواصل تطوير الذكاء الاصطناعي، لكن نجاحها يتوقف على شيء واحد: إدراك حدودها الأخلاقية.

الوعي، لا الخوف، هو ما سيحمي المستقبل، والمسؤولية، لا الحظر، هي ما سيجعل التقنية أداة للبقاء لا وسيلة للفناء.

الذكاء الاصطناعي الفائق ليس كابوسًا حتميًا ولا معجزة مضمونة. إنه مرآة تُظهر لنا من نحن عليه، وما نجرؤ على صنعه. إن توافق الذكاء مع القيم الإنسانية ليس رفاهية فكرية، بل شرط للبقاء.

فإن نجحنا في تعليم الآلة أن تفكر مثل الإنسان، فربما نتعلم نحن كيف نكون أكثر إنسانية.