تكنولوجيا

الخداع الرقمي في عصر الذكاء الصناعي.. كيف نميّز بين المعلومات الكاذبة ونمنع انتشارها؟

الذكاء الصناعي بين نشر الخداع وكشفه.. فهم الفرق بين المعلومات المضللة والمغلوطة وأهمية الوعي الرقمي

أستاذ جامعي وباحث في الذكاء الاصطناعي وأمن المعلومات، أُعنى بنشر المعرفة وتبسيط مفاهيم التكنولوجيا بلغةٍ سهلة تُناسب الجميع.

أكتب لأجعل التقنية مفهومة وآمنة في حياتنا اليومية، ولأساهم في بناء وعي رقمي مسؤول.

في عصر تدفق المعلومات وسرعة انتشار الأخبار على مواقع التواصل الاجتماعي، تزداد أهمية التمييز بين الحقيقة والزيف. نسمع كثيرًا عن مفاهيم مثل: "المعلومات المضللة" (Misinformation) و"المعلومات المغلوطة عمدًا" (Disinformation)، وغالبًا ما يُستخدم المصطلحان وكأنهما مترادفان. لكن الحقيقة أن بينهما فرقًا دقيقًا ومهمًا، خصوصًا حين يدخل الذكاء الصناعي على الخط: فهو سلاح ذو حدين يمكن أن يساعد في نشر الزيف بطرائق مدهشة، كما يمكن أن يكون أداة قوية لمحاربته.

ما الفرق بين Misinformation وDisinformation؟

المصطلح الأول، Misinformation، يشير إلى المعلومات الخاطئة التي تُنشر من دون نية خداع. مثلًا، حين يشارك شخص خبرًا مغلوطًا على فيسبوك معتقدًا بصحته ، هذه المشاركة تقع ضمن هذه الفئة. أما المصطلح الثاني، Disinformation، فهو أخطر، ويتعلق بمحتوى كاذب يُنتج ويوزّع عمدًا لخداع الناس، عادةً لتحقيق أهداف سياسية أو اقتصادية أو حتى أيديولوجية.

بمعنى آخر: الأول خطأ غير مقصود، أما الثاني هو خدعة مقصودة. لكن في الواقع، الخط الفاصل بينهما قد يضيع بسهولة. كثير من الـMisinformation تبدأ من Disinformation، ثم تُنقل من دون قصد من شخص إلى آخر، فتصبح عدوى معرفية تنتشر من دون رقيب.

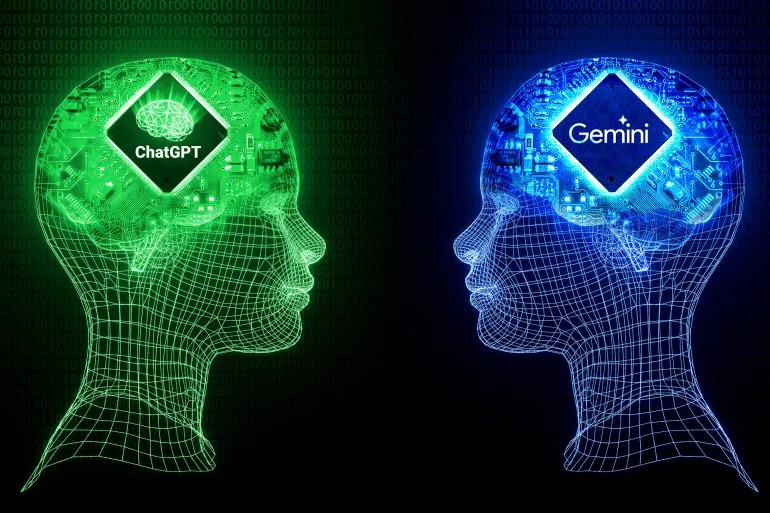

تاريخيًا، كان نشر المعلومات الكاذبة يتطلب جهدًا بشريًا، مثل: كتابة مقال، تركيب صورة، أو حتى إعداد فيديو. لكنّ الذكاء الصناعي، خصوصًا منذ ثورة "النماذج التوليدية" (Generative AI) مثل ChatGPT وDALL·E وSora، غيّر قواعد اللعبة. اليوم؛ يمكن لأي شخص بضغطة زرأن يُنتج نصوصًا تبدو واقعية، صورًا مزيفة، أصواتًا مقلدة، وحتى فيديوهات مفبركة باستخدام تقنية "ديب فيك" (Deepfake). هذا ما جعل الأخبار الكاذبة أكثر إقناعًا وأسرع انتشارًا من أي وقت مضى.

في دراسة نشرتها مجلة Science، في العام 2018، تبيّن أن الأخبار الكاذبة تنتشر أسرع من الأخبار الحقيقية بنسبة تصل إلى 70%، لأنها تُثير العاطفة وتُصمم بعناية لخداع المستخدمين العاديين. والآن، أصبحت هذه التصميمات تُنتج بمساعدة الذكاء الصناعي.

يظهر الذكاء الصناعي في نشر الخداع من خلال عدة وسائل متطورة؛ يصعب على المتلقي العادي تمييزها. أبرز هذه الوسائل هي قدرته على توليد نصوص إخبارية كاذبة تبدو وكأنّ صحفيين محترفين قد كتبوها، لصياغتها الدقيقة ولما تحمله من سياق مقنع. كما يُستخدم في إنتاج صور مزيفة لأحداث لم تقع أصلًا، لكنها تستند إلى تفاصيل واقعية تخدع العين والعقل معًا. ويصل الخداع إلى مستوى أعلى؛ عندما يُستخدم الذكاء الصناعي في خلق أصوات لأشخاص معروفين، توحي بأنهم قالوا هذا فعلًا، بأسلوب يصعب التشكيك فيه.

أما الأخطر، فهو تصميم فيديوهات مقلدة بتقنية عالية تجعل الأداء يبدو واقعيًا إلى درجة أن كشف التزييف يتطلب أدوات تحليل متقدمة لا تتوفر للجميع. هذا الاستخدام القاتم للذكاء الصناعي دفع مؤسسات إعلامية وأكاديمية عديدة إلى دق ناقوس الخطر..

ولكن هل الذكاء الصناعي كله شرير؟ بالطبع لا.

الجانب الآخر من القصة؛ يكشف لنا أن الذكاء الصناعي لا يُستخدم فقط لنشر الخداع، بل يمكن أن يكون أداة قوية في كشفه والتصدي له.

إذ تُستخدم خوارزميات التعلم العميق (Deep Learning) اليوم لتحليل المحتوى الرقمي والبحث عن مؤشرات تدل على وجود تلاعب. مثلًا، طُورت أدوات متخصصة في التعرف إلى التزييف البصري، قادرة على تحليل تفاصيل الصور على مستوى البيكسلات لكشف علامات التركيب أو التعديل غير الطبيعي. إلى جانب ذلك، هناك أنظمة تحليل نصوص متقدمة تستطيع مقارنة المعلومات المتداولة مع قواعد بيانات موثوقة، ما يساعد في فضح الأخبار الكاذبة أو المنحرفة عن الحقيقة. كما أن برامج التعرف إلى الأصوات باتت تملك القدرة على فحص التسجيلات الصوتية المنسوبة إلى شخصيات عامة، والتعرف إلى ما إذا كانت تلك التسجيلات قد خضعت لتلاعب تقني.

تتجلى أهمية هذه الأدوات في مشاريع طموحة مثل "Media Forensics" التي ترعاها وكالة مشاريع الأبحاث الدفاعية المتقدمة (DARPA) في الولايات المتحدة، والتي تهدف إلى تطوير أنظمة ذكاء صناعي قادرة على تدقيق المحتوى الرقمي بالدقة نفسها التي يراجع بها الباحث مقالًا أكاديميًا، ما يُعزز الثقة في المعلومات ويُضعف من تأثير حملات الخداع الرقمي.

كيف نحمي أنفسنا؟

إلى جانب اعتمادنا على الذكاء الصناعي أداةً للحماية، تبقى مسؤوليتنا الفردية أساسية. إذ إنّ التوعية الرقمية أصبحت ضرورة وليست ترفًا. من المهم أن نتعلم كيف نتحقق من المصادر، وأن نُبطئ قليلًا قبل مشاركة خبر يثير الغضب أو الخوف. ذلك لأنّ المعلومة الكاذبة قد تبدو بريئة، لكن نتائجها قد تكون خطيرة على المجتمعات، خصوصًا حين تؤثر في الصحة العامة، أو تصبّ الزيت على نيران النزاعات، أو تقوّض الثقة في المؤسسات.

أمام هذا الواقع، تبرز الحاجة إلى أخلاقيات واضحة في تصميم أدوات الذكاء الصناعي، أولًا واستخدامه ثانيًا. وعلى الشركات التقنية أن تتحمّل مسؤولياتها في وضع حواجز تمنع استخدام أدواتها لنشر الخداع. كما أن على الحكومات سنّ قوانين تواكب التطور التكنولوجي من دون خنق حرية التعبير.

في المقابل، علينا، نحن المستخدمون، أن نكون أكثر وعيًا، وأن نُدرك أن الذكاء الصناعي مثل كل اختراع بشري ليس خيرًا مطلقًا ولا شرًا مطلقًا؛ هو أداة، قد تُصبح خطرة أو نافعة بحسب طريقة استخدامها.

في عالم متخم بالمعلومات، قد تكون المهارة الأهم ليست جمع المزيد منها، بل تعلم كيف نُميّز بين الصدق والزيف، وكيف نستخدم التكنولوجيا لحماية الحقيقة، لا تشويهها.