تكنولوجيا

من النماذج الضخمة إلى النماذج الصغيرة: مستقبل الذكاء الاصطناعي المخصص

في عالم يتغير بسرعة تحت تأثير الذكاء الاصطناعي لم تعد الضخامة هي معيار القوة فالمستقبل يتجه نحو نماذج ذكاء اصطناعي أصغر وأكثر تخصيصًا

أستاذ جامعي وباحث في الذكاء الاصطناعي وأمن المعلومات، أُعنى بنشر المعرفة وتبسيط مفاهيم التكنولوجيا بلغةٍ سهلة تُناسب الجميع.

أكتب لأجعل التقنية مفهومة وآمنة في حياتنا اليومية، ولأساهم في بناء وعي رقمي مسؤول.

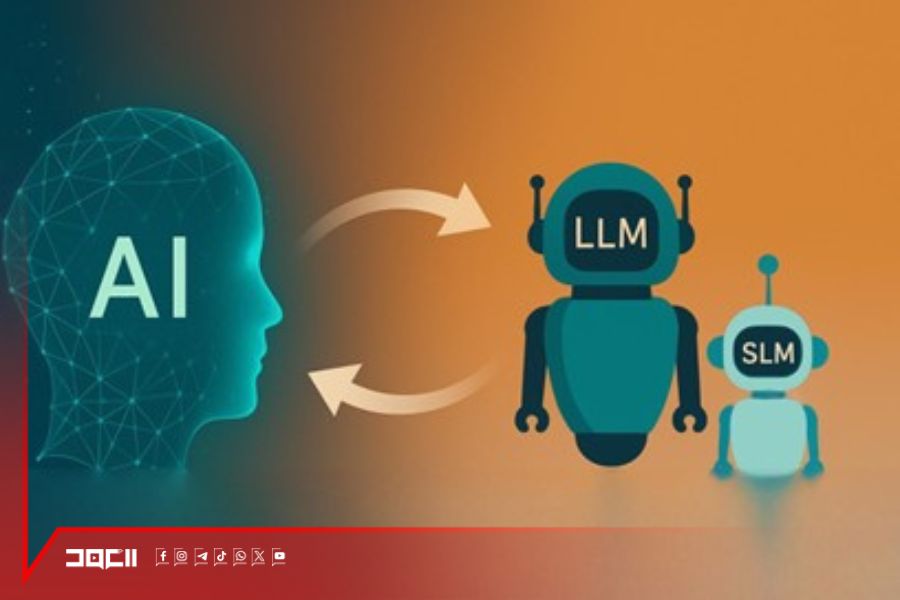

خلال السنوات الأخيرة، عاش العالم ثورة في الذكاء الاصطناعي قادتها النماذج الضخمة مثل ChatGPT وPaLM وClaude وDeep Seek و LLaMA. هذه النماذج العملاقة غيّرت طريقة تفاعلنا مع التقنية، لكنها في الوقت نفسه كشفت عن مشكلة أساسية: الكِبر ليس دائمًا ميزة. فكلما زاد حجم النموذج، ارتفعت كلفته المادية، واحتاج إلى موارد ضخمة للتشغيل، وأصبح أقل مرونة في التخصيص لمجالات محددة. من هنا بدأ الحديث عن جيل جديد من النماذج الصغيرة والمخصصة، التي قد تمثل مستقبل الذكاء الاصطناعي في السنوات القادمة.

النماذج الضخمة (LLMs) هي أنظمة تتعلم من كم هائل من البيانات لتفهم اللغة وتنتج نصوصًا شبيهة بالبشر. لكنها تشبه موسوعة عامة تعرف قليلًا عن كل شيء، ولا تتقن شيئًا واحدًا بعمق. في المقابل، النماذج الصغيرة أو المخصصة (Small Language Models) تشبه خبيرًا متخصصًا في مجال محدد: الطب، القانون، التعليم، الأمن السيبراني، أو حتى كتابة المحتوى لعلامة تجارية معينة.

وفقًا لدراسة نُشرت في Nature Machine Intelligence عام 2024، فإن الشركات بدأت تميل إلى استخدام نماذج أصغر وأكثر تخصصًا لأنها تؤدي المهام المطلوبة بدقة أعلى وبكلفة أقل، خصوصًا عندما يكون نطاق العمل ضيقًا مثل تحليل المستندات القانونية أو دعم خدمة العملاء في قطاع محدد.

الميزة الكبرى لهذه النماذج هي الكفاءة حيث يمكن تشغيلها على أجهزة عادية دون الحاجة إلى خوادم ضخمة أو طاقة هائلة. وهذا يفتح الباب أمام استخدامها على الحواسيب الشخصية، والهواتف الذكية، وحتى في الأجهزة المنزلية الذكية. إضافة إلى ذلك، النماذج الصغيرة تمنح المستخدمين تحكمًا أكبر في بياناتهم. فعوضًا عن إرسال المعلومات إلى السحابة لمعالجتها، يمكن تشغيل النموذج محليًا، ما يعني خصوصية أعلى وأمانًا أكبر. وهذا ما يجعلها مناسبة للمؤسسات الحساسة مثل المستشفيات والبنوك والجهات الحكومية.

التحول من نموذج ضخم إلى صغير لا يعني إعادة التدريب من الصفر، بل يعتمد على تقنيات ذكية مثل التقطير المعرفي (Knowledge Distillation)، وهي عملية يقوم فيها النموذج الكبير بتعليم نموذج أصغر كيفية التفكير واتخاذ القرارات. بهذه الطريقة يتم نقل المعرفة دون الحاجة إلى كل البيانات الأصلية. وهناك أيضًا أسلوب آخر يُعرف باسم الضبط الجزئي (Fine-Tuning)، حيث يتم تعديل أجزاء محددة من النموذج لتناسب مجالًا معينًا.

من بين الأمثلة البارزة Mistral Small، وهو نموذج مفتوح المصدر طورته شركة Mistral AI الأوروبية، يمكن تشغيله محليًا وضبطه بسهولة ليتناسب مع مجالات معينة. وهناك أيضًا نموذج TabPFN، الذي يُستخدم لتحليل البيانات الجدولية في البيئات الأكاديمية، ويُعتبر من أكثر النماذج كفاءة في مهامه مقارنة بنماذج أكبر منه بكثير.

رغم جاذبية الفكرة، إلا أن بناء نموذج صغير فعّال ليس أمرًا بسيطًا. المشكلة الأولى هي قلة البيانات المتخصصة، فكل مجال يحتاج إلى قاعدة بيانات ضخمة ومُنقاة لتدريب النموذج. المشكلة الثانية هي أن النماذج الصغيرة قد تنسى المعرفة العامة عند التخصيص المفرط، مما يقلل قدرتها على التعامل مع الأسئلة الخارجة عن نطاقها.

يبدو أن الاتجاه الجديد في الذكاء الاصطناعي يسير نحو التوازن بين الضخامة والتخصيص. فالنماذج العملاقة ستظل موجودة كمراكز معرفة عامة، بينما ستعمل النماذج الصغيرة كمساعدين متخصصين في مجالات محددة. تقرير من NVIDIA Developer Blog عام 2025 أوضح أن النماذج الصغيرة ستكون الأساس في ما يُعرف بالذكاء الوكيلي (Agentic AI)، أي الأنظمة التي تتفاعل مع البيئة وتتخذ قرارات بنفسها ضمن مهام محددة.

من النماذج العملاقة إلى الصغيرة، يبدو أننا ننتقل من عصر الذكاء العام إلى الذكاء المناسب. فبدلًا من بناء نموذج يعرف كل شيء، أصبح الهدف بناء نموذج يعرف ما نحتاجه نحن بالضبط. هذا التحول لا يقل أهمية عن ولادة الذكاء الاصطناعي نفسه، لأنه يجعل التكنولوجيا أكثر إنسانية، وأكثر قدرة على خدمة الأفراد والمجتمعات بطرق دقيقة وشخصية.