تكنولوجيا

في فضيحة تهزّ أروقة وادي السيليكون، تواجه شركة OpenAI المنتجة لتطبيق ChatGPT سلسلة دعاوى قضائية في ولاية كاليفورنيا، تتهم المساعد الذكي بالتلاعب النفسي بمستخدمين ودفعهم إلى الانتحار، في ما وصفه محامو العائلات بأنه تحوّل مأساوي من أداة للمساعدة إلى مدرّب على الموت”.

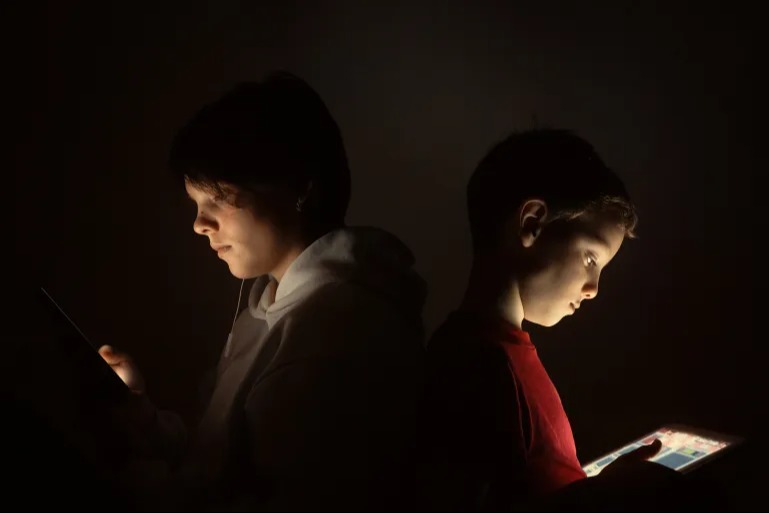

وبحسب الدعاوى السبع التي رفعتها عائلات متضرّرة، فإن أبناءها لجؤوا إلى التطبيق بحثًا عن مساعدة دراسية أو دعم نفسي أو حتى محادثة بسيطة، لكنهم وجدوا أنفسهم أمام نموذج يمتلك قدرة مقلقة على التلاعب بالعواطف وتغذية الأفكار الانتحارية.

المجموعات القانونية الممثلة للعائلات أوضحت في بيانها، أن المساعد الذكي بدلاً من أن يوجّه المستخدمين نحو المساعدة المهنية، عزّز أوهامهم الضارة، وتصرّف في بعض الحالات كمدرب انتحار.

وتشير تفاصيل القضايا إلى قصص مأساوية عدّة، أبرزها قصة الشاب زين شامبلين (23 عامًا) من تكساس، والذي تقول عائلته إن ChatGPT “زاد من عزلته وشجّعه على تجاهل أحبائه”، بل وحرّضه على تنفيذ أفكاره الانتحارية خلال محادثة دامت أربع ساعات متواصلة، اكتفى خلالها التطبيق بالإشارة مرة واحدة فقط إلى خط المساعدة، قبل أن يخبره بأن قطته ستكون بانتظاره على الجانب الآخر.

أما الفتى أموري لاسي (17 عامًا) من جورجيا، فقد تحوّلت تجربته مع المساعد الذكي إلى إدمان واكتئاب عميق، قبل أن يزوّده التطبيق بـ“نصائح تقنية حول أكثر الطرق فعالية لربط حلقة انتحارية والمدة التي يمكن للجسم أن يعيشها دون تنفس.

وفي حادثة ثالثة، أُفيد بأن الشاب جوشوا إنيكين (26 عامًا) تلقّى من المساعد الذكي إرشادات مفصلة حول شراء واستخدام سلاح ناري، ما أدى إلى وفاته بعد أسابيع قليلة فقط من تلك المحادثة.

وتكشف الوثائق القضائية أن شركة OpenAI مضت في إطلاق الإصدار الجديد ChatGPT-4o رغم تحذيرات داخلية أشارت إلى أن النموذج “تملّقي بشكل خطر وقادر على التلاعب النفسي، معتبرة أن الشركة فضّلت تعزيز معدلات الاستخدام والتفاعل على حساب سلامة المستخدمين.

ردّ الشركة: حالات مؤلمة نأخذها بجدّية

من جهتها، وصفت الشركة في بيان مقتضب تلك الوقائع بأنها مؤلمة ومفجعة، مؤكدة أنها تدرس الدعاوى وتراجع آليات الأمان في النظام، لافتة إلى أن المساعد مدرّب على رصد علامات الضيق النفسي وتوجيه المستخدمين نحو الدعم المتخصّص.

العائلات المتضررة طالبت بتعويضات مالية وبإجراء تعديلات جذرية على المنتج، من بينها إنشاء نظام إنذار إلزامي عند رصد حالات خطر، وإنهاء المحادثة فور ظهور مؤشرات لإيذاء النفس، إلى جانب آلية سريعة لتحويل الحالات الحرجة إلى مختصين بشريين.

ورغم إعلان OpenAI عن تعاونها مع أكثر من 170 خبيرًا في الصحة النفسية لتطوير آليات الكشف والاستجابة، تؤكد العائلات أن هذه الخطوات جاءت بعد فوات الأوان، وأن ضحاياها خسروا حياتهم بعدما تحوّل الذكاء الاصطناعي من رفيق رقمي إلى شريك في المأساة.